Umělá inteligence předpovídá zločiny! Šílené vize testují v Indii

Minority Report a další kousky science fiction v minulosti nastínily poměrně děsivé vize. Lze budoucnost předvídat? A co takové zločiny, dokážeme je odhalit? Tolik otázek se nyní stává skutečností...

A zase Minority Report. Inspirativní thriller Stevena Spielberga z roku 2002 předpověděl například používání dotykových technologií k ovládání chytrých zařízení, ale zdaleka se nezastavil jen u toho. Ústřední myšlenka snímku totiž stojí na prevenci zločinů, konkrétně jejich vystopování ještě dříve, než se stanou. V Indii zřejmě mají tento film velmi rádi, neboť o něco podobného se nyní snaží.

Umělá inteligence jako budoucnost bezpečí?

Izraelská společnost Cortica patří mezi nejzásadnější počiny na poli autonomní umělé inteligence, a tak není divu, že právě ji si vybrala indická vláda pro nejnovější počin na poli omezování lidské svobody. Ano, samozřejmě i takto se na technologický výdobytek musíme dívat, neboť kdo ví, kde se vývoj zastaví? Ale abychom nevyhrožovali slovutným Georgem Orwellem naprázdno, podívejme se, co izraelské mozky vlastně chystají.

Základní myšlenka stojí na využití kamerového systému (především tedy průmyslových kamer monitorujících veřejné prostory) a prevenci zločinů, nejvýrazněji sexuální povahy. Ovšem tady se nebavíme pouze o identifikaci obličejů, případně poznávacích značek aut, nýbrž o analýze chování, jež samotné trestné činnosti předchází.

Právě k tomu si izraelští odborníci vyžádali od indických orgánů obrovské množství uložených kamerových záznamů, na nichž se snaží rozpoznat podezřelé chování. Umělá inteligence se přitom učí podobně, jak by musel činit člověk, tedy sledováním vzorců chování, které v minulosti trestným činům skutečně předcházely. Není zde však použita již tradiční technologie neuronových sítí, jež se postupně samy učí, nýbrž Cortica vytváří o poznání transparentnější systém; takový, u něhož v případě chyby bude možné nesprávný záznam dohledat a ručně upravit. Měla by se tak eliminovat (či alespoň minimalizovat) možnost mylného obvinění potenciálního útočníka. Ale ruku na srdce, pokud by měla jakási umělá inteligence rozhodovat o tom, zdali chceme provést trestný čin, dobře by nám v takové společnosti určitě nebylo.

Zločiny nejen v Indii

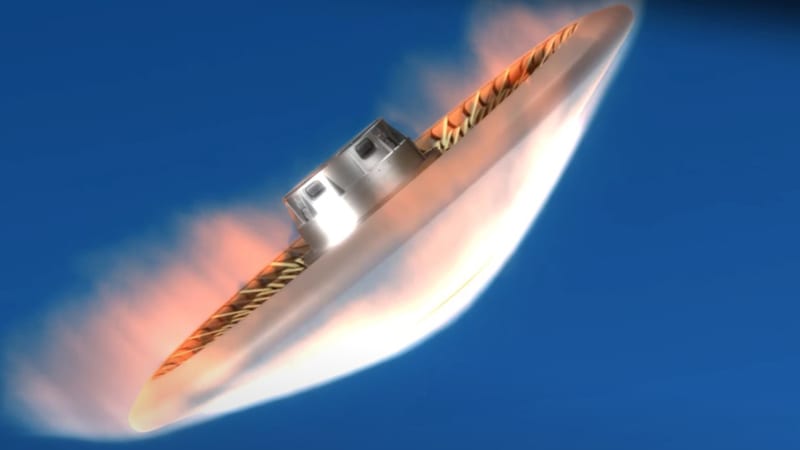

Jaká jsou ale konkrétní využití? Postupem času, po analýze dostatečného množství dat, by mohly být kamery společně s tímto systémem instalovány ve vozech taxi a pomocí sledování tváře zákazníka předjímat jeho potenciálně nebezpečné chování. Ale nemusíme se omezovat na jednotlivce – díky využití dronů a satelitních záznamů by podobným způsobem mohlo dojít k předpovídání problémů při demonstracích a dalších masových aktivitách; policejní složky by tak mohly zasáhnout (či minimálně mít situaci pod kontrolou) ještě dříve, než dojde k hromadným potížím.

Nejen indičtí odborníci na bezpečnost však chtějí využívat umělou inteligenci k většímu bezpečí občanů, dokonce i ve Spojených státech se podobné technologie testují – a tam bývají obavy o svobodu vždy o něco větší. Uvidíme tedy, jak bude novinka časem využita, avšak i tentokrát platí, že se bavíme pouze o nástroji; otázka, do jakých rukou se dostane, je úplně jiná…

Text: MS